知识列表

- 物理页面大小选择的依据是什么?为什么常选择4KB大小的页面

- 程序从堆中动态分配内存时,虚拟内存上如何操作的?

- 交换空间与虚拟内存的关系是什么

- 常见的内存分配方式

- 常见的内存分配错误

- 页表的构成和作用

- 分页的好处

- 页面置换算法

- CPU 缓存如何影响计算性能?解释缓存的概念

- 超线程、

- 文件系统在创建文件时进行了哪些底层操作

- 非阻塞 I/O 与异步 I/O 的区别及其实现机制

- 直接 I/O(Direct I/O)和页面缓存(PageCache)的作用是什么

- 文件系统在WIndows和Linux下的差异

- 磁盘 I/O 的工作原理是什么

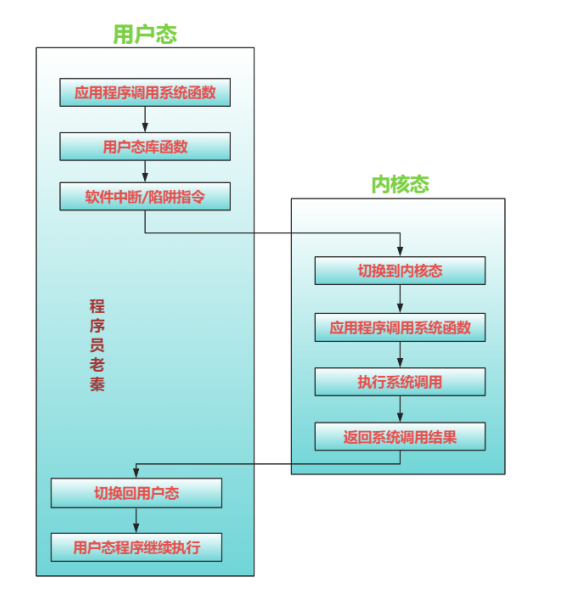

- 系统调用是如何工作的

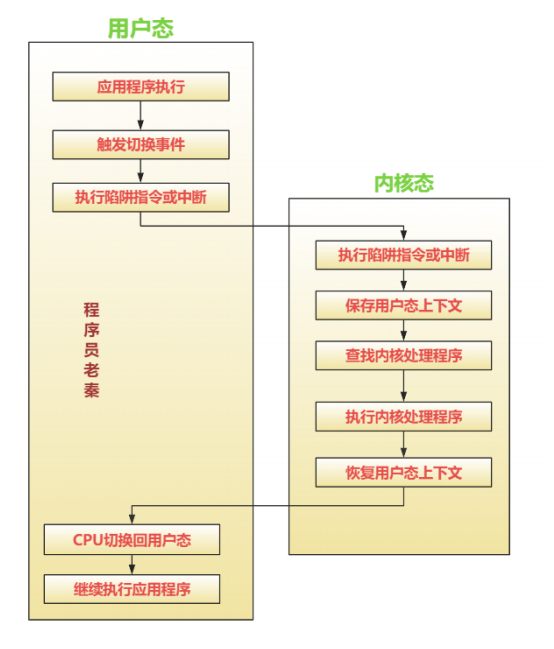

- 用户态与内核态之间如何切换

- 中断的原理及其实现

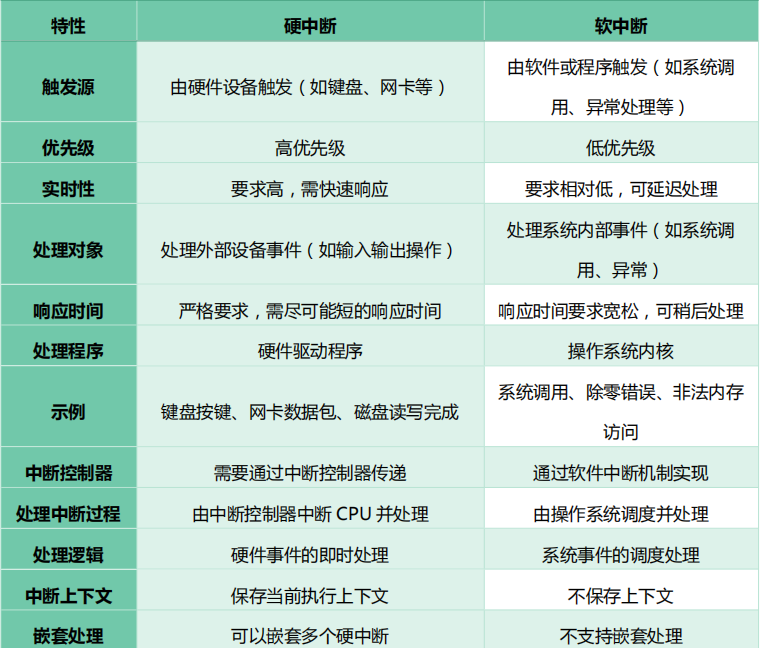

- 硬中断和软中断的区别

- 如何减少用户态与内核态的切换

- 如何使用 GDB 工具调试

- 如何检测死锁

- Coredump 文件是如何生成的?如何利用它进行错误分析

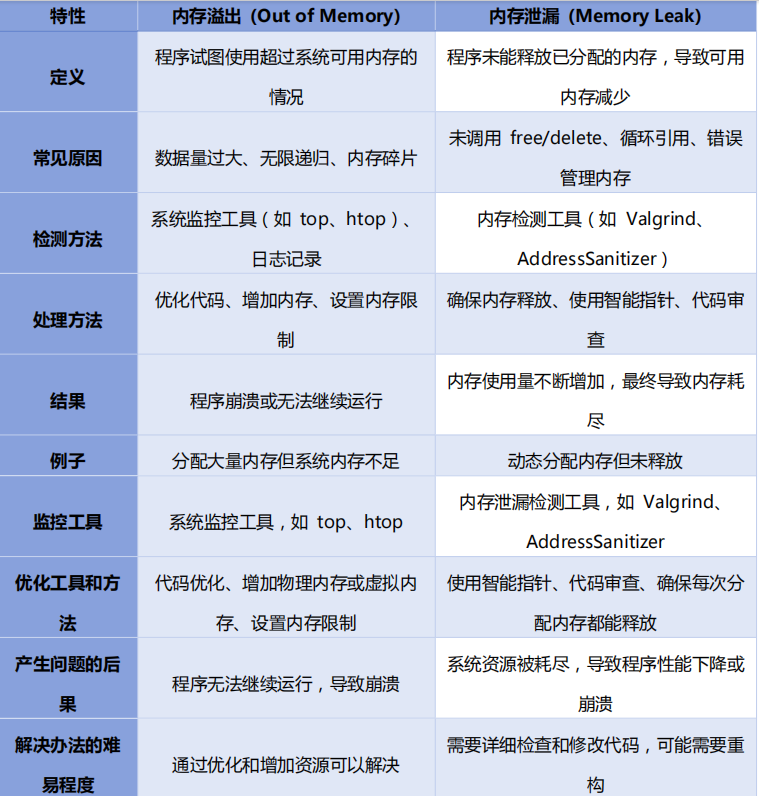

- 内存溢出与内存泄漏有什么不同?

- 调试方法有哪些?说出优缺点?

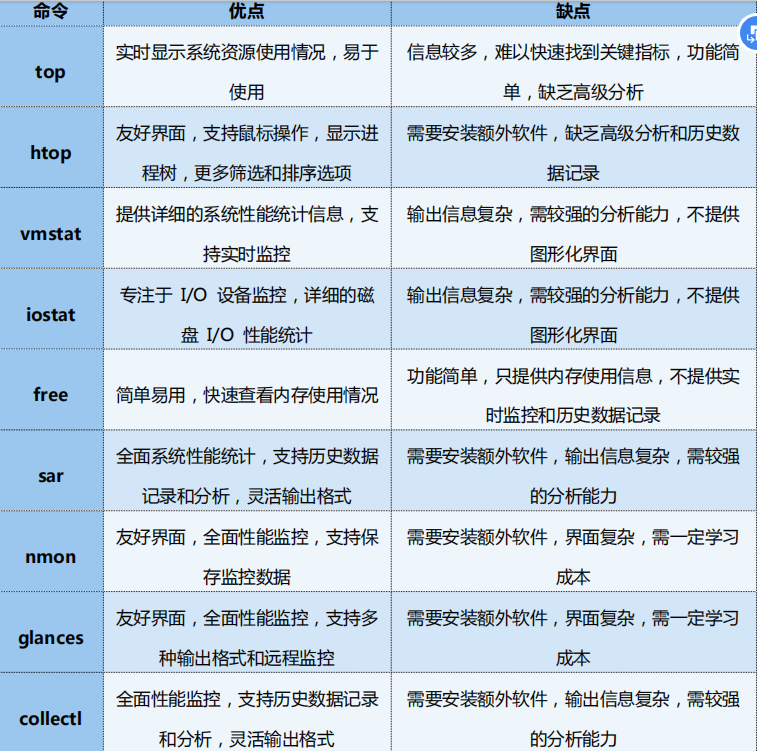

- 如何监控服务器 CPU 信息、内存使用率?

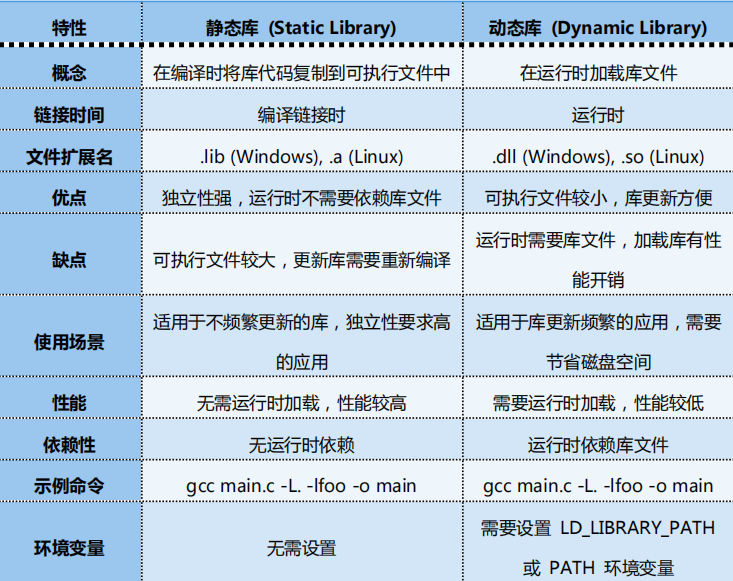

- 动态库与静态库的区别?

- 编译器按字节对齐的原因是什么

- 字节序及其对系统的影响

- 源码到可执行文件的过程是什么

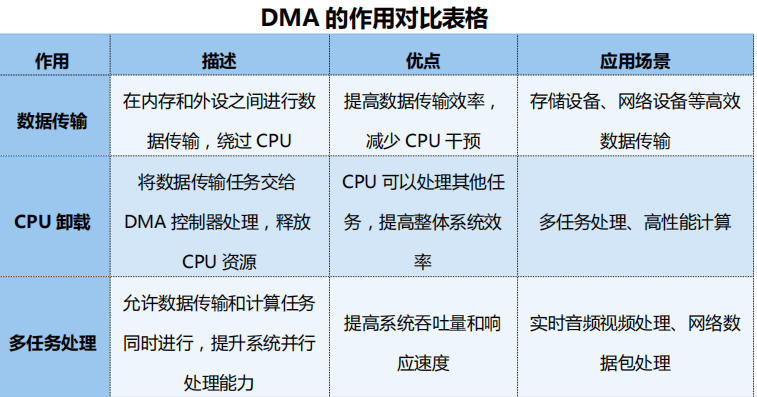

- DMA

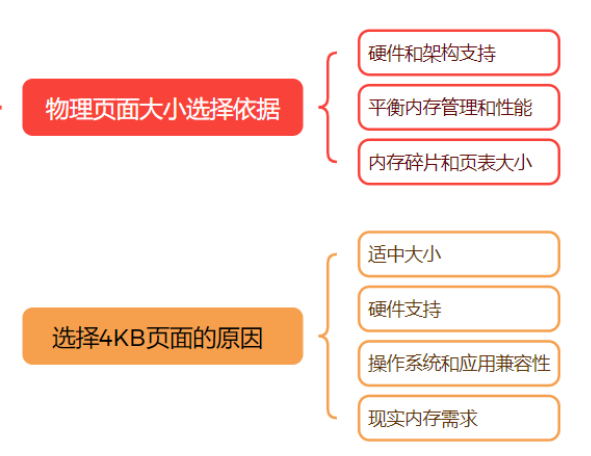

1.物理页面大小选择的依据是什么?为什么常选择4KB大小的页面

物理页面大小选择的依据是什么

- 平衡内存管理和性能1)内存管理:页面大小影响内存管理的效率。较大的页面可以减少页表的大小和管理开销,但可能导致更大的内存碎片。较小的页面可以减少内存碎片,但增加页表的大小和管理开销。2)性能:页面大小对内存访问性能有直接影响。较大的页面可以减少页面故障的频率,提高内存访问性能。较小的页面可以提高内存的使用效率,但可能增加页面故障的频率。

- 内存碎片和页表大小1)内存碎片:内存碎片是内存管理中的一个重要问题。较大的页面可能导致更多的内部碎片,而较小的页面可以减少这种碎片。2)页表大小:页表记录虚拟地址到物理地址的映射关系。较大的页面可以减少页表条目的数量,从而减少页表的大小和管理开销

- 硬件和架构支持1)硬件支持:不同的硬件架构支持不同的页面大小。选择页面大小时需要考虑硬件的支持情况。2)架构特性:某些架构可能对特定大小的页面有优化,选择合适的页面大小可以充分利用这些优化特性

为什么常选择4KB大小的页面

(1)适中大小:

1)平衡性:4KB 页面在内存碎片和页表大小之间取得了良好的平衡。它足够小,可以减少内存

碎片,同时也足够大,可以保持页表的合理大小。

2)广泛适用:4KB 页面大小适用于大多数应用场景,能够满足大多数操作系统和应用程序的内

存需求。

(2)硬件支持:

1)普遍支持:多数现代硬件架构(如 x86、ARM 等)对 4KB 页面有良好的支持。这种广泛的

硬件支持使得 4KB 页面成为默认选择。

2)性能优化:许多硬件架构对 4KB 页面进行了特定的性能优化,使用 4KB 页面可以充分利用

这些优化特性。

(3)操作系统和应用兼容性:

1)操作系统标准:许多操作系统(如 Linux、Windows)使用 4KB 作为标准页面大小,确保

了广泛的兼容性。

2)应用程序兼容:许多应用程序设计和优化时考虑到了 4KB 页面大小,选择 4KB 页面可以确

保这些应用程序的正常运行和最佳性能。

(4)现实内存需求:

1)内存需求:4KB 页面大小能够满足大多数应用程序的内存需求。对于需要大量小块内存的应

用程序,4KB 页面可以有效减少内存碎片,提高内存利用率。

2)灵活性:4KB 页面大小提供了良好的灵活性,能够适应不同的内存分配需求。

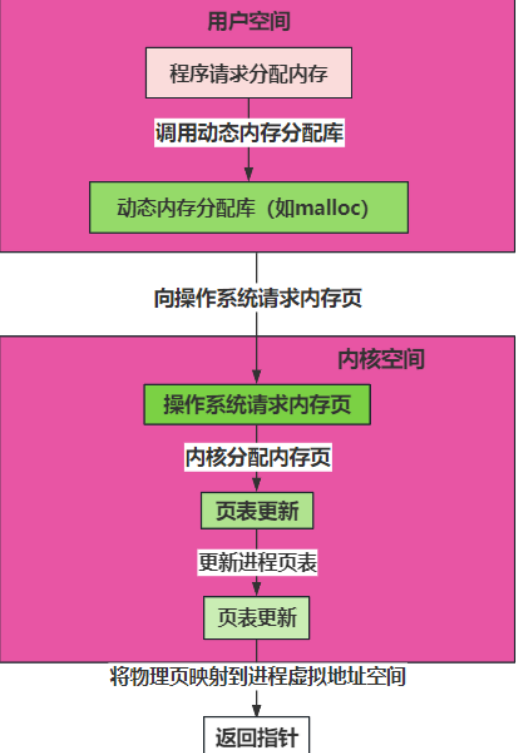

2.程序从堆中动态分配内存时,虚拟内存上如何操作的?

(1)程序请求分配内存:使用动态内存分配函数(如 malloc、new)。

(2)动态内存分配库:处理内存请求,可能会调用系统调用(如 brk、sbrk、mmap)。

(3)操作系统请求内存页:如果需要,操作系统为进程分配新的物理内存页。

(4)页表更新:操作系统更新页表,映射新的虚拟内存页到物理内存页。

(5)内存映射:虚拟地址与物理地址建立映射关系。

(6)返回指针:动态内存分配函数返回指向分配内存的指针。

3.交换空间与虚拟内存的关系是什么

(1)交换空间(Swap Space):

1)内存换出(Swap Out):将不常用的内存页从物理内存移到交换空间,以释放物理内存。

2)内存换入(Swap In):当需要访问已换出的内存页时,将其从交换空间移回物理内存。

(2)交换空间在虚拟内存中的作用

1)扩展内存容量:通过交换空间,操作系统可以将物理内存和磁盘上的交换空间结合使用,提

供比实际物理内存更大的可用内存容量。

2)提高内存利用率:将不常用的内存页移到交换空间,释放物理内存给更需要的进程使用,提

高内存利用率。同时操作系统动态调整内存换出和换入的频率,保持内存的高效利用。

3)减少内存不足引起的错误:当物理内存不足时,通过交换空间提供额外的存储,避免程序因

内存溢出而崩溃。

4.常见的内存分配方式

(1)静态内存分配:在编译时分配内存,大小固定,生命周期与程序相同。

(2)栈内存分配:在函数调用时分配内存,自动管理,速度快,生命周期短。

(3)堆内存分配:动态内存分配,大小灵活,需要手动管理,速度相对较慢。

(4)内存池分配:预先分配固定大小的内存块,提高内存分配和释放的效率,减少碎片。

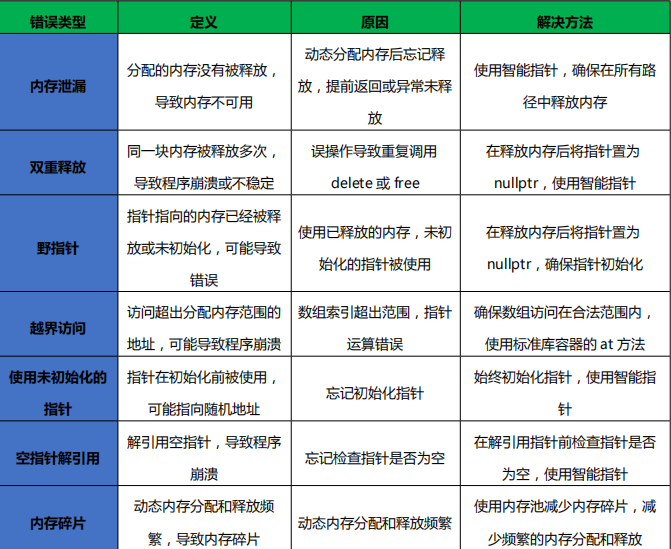

5.常见的内存分配错误

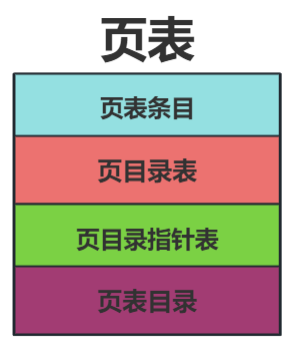

6.页表的构成和作用

(1)页表的构成

1)页表条目(PTE,Page Table Entry):

定义:页表条目是页表的基本单元,每个条目对应一个虚拟页。

内容:包含物理页框号(PFN,Physical Frame Number)和控制位(如有效位、读写位、用

户/内核模式位等)。

2)页目录表(PD,Page Directory):

定义:页目录表包含多个页表条目的集合。

内容:每个条目指向一个页表,页表条目进一步指向实际的物理内存页。

3)页目录指针表(PDP,Page Directory Pointer):

定义:页目录指针表包含多个页目录表的指针。

内容:每个条目指向一个页目录表,页目录表包含页表的指针。

4)页表目录(PML4,Page Map Level 4):

定义:页表目录是最高层的页表结构,包含多个页目录指针表的指针。内容:每个条目指向一个页目录指针表,页目录指针表包含页目录表的指针。

(2)页表的作用

1)虚拟地址到物理地址映射:

作用:页表的主要作用是将虚拟地址映射到物理地址,使得操作系统能够使用虚拟内存。

过程:CPU 生成虚拟地址,通过 MMU(内存管理单元)查找页表。页表各级查找,最终找到

对应的物理地址。

2)内存保护:

作用:页表通过控制位实现对内存访问的权限控制,提供内存保护。

有效位(Present bit):指示该页是否在内存中。

读写位(Read/Write bit):控制该页的读写权限。

用户/内核模式位(User/Supervisor bit):控制该页的访问模式(用户模式或内核模式)。

3)支持虚拟内存管理:

作用:页表支持虚拟内存管理,使得进程可以使用比物理内存更大的地址空间。

换页机制:当内存不足时,操作系统可以将不常用的页换出到磁盘上的交换空间,释放物理内

存。当需要访问已换出的页时,操作系统将其从交换空间换入到物理内存。

7.分页的好处

(1)简化内存管理:分页将内存划分为固定大小的页和页框,简化了内存的分配和回收。

(2)提供内存保护:分页支持页面级的权限控制,防止进程非法访问其他进程的内存。

(3)支持虚拟内存:通过分页可以实现虚拟内存,使得进程可以使用比物理内存更大的地址空间。

(4)减少内存碎片:分页避免了内存分配中的外部碎片问题,提高了内存利用率。

(5)提高内存利用率:分页支持按需加载和交换,优化了内存使用。

(6)提供地址空间隔离:每个进程拥有独立的页表,确保了地址空间的隔离,提高了系统的稳定

性和安全性。

8.页面置换算法

(1)FIFO(先进先出)

1)定义:按照页面进入内存的顺序进行置换,最先进入的页面最先被置换。

2)过程:每次页面进入内存时,记录进入顺序。当需要置换时,选择最早进入内存的页面进行

置换。

3)优点:实现简单,易于理解。

4)缺点:性能不佳,可能会置换掉仍然需要的页面(Belady’s Anomaly)。

(2)LRU(最近最少使用)

1)定义:置换最近最少使用的页面。

2)过程:每次页面被访问时,更新其使用时间。当需要置换时,选择最近最少使用的页面进行

置换。

3)优点:性能好,适用于大多数场景。4)缺点:实现复杂,需要维护页面使用时间的数据结构。

(3)LFU(最不常使用)

1)定义:置换访问频率最低的页面。

2)过程:每次页面被访问时,更新其访问频率。当需要置换时,选择访问频率最低的页面进行

置换。

3)优点:适用于访问频率有规律的场景。

4)缺点:容易产生“长期不变”现象,老页面可能一直占用内存。

(4)Clock(时钟算法)

1)定义:FIFO 的改进版,提供“第二次机会”机制。

2)过程:每个页面有一个“访问位”。当需要置换时,检查页面的“访问位”:如果为 0,置

换该页面。如果为 1,将其置为 0,并检查下一个页面。

3)优点:性能较好,避免置换掉仍然需要的页面。

4)缺点:实现稍复杂,需要维护一个时钟指针。

(5)Optimal(最佳置换算法)

1)定义:理论最优算法,选择将来最久不使用的页面进行置换。

2)过程:预测每个页面的未来使用情况。当需要置换时,选择将来最久不使用的页面进行置换。

3)优点:提供最优性能。

4)缺点:实际不可实现,仅用于评估其他算法。

(6)NRU(未使用最近算法)

1)定义:根据访问位和修改位进行分类,随机选择置换。

2)过程:页面有两个位:访问位和修改位。每个时钟周期清除访问位。

分为四类:

访问位=0,修改位=0

访问位=0,修改位=1

访问位=1,修改位=0

访问位=1,修改位=1 随机选择最低类进行置换。

3)优点:实现简单,性能较好。

4)缺点:可能不如 LRU 和 Clock 算法高效。

(7)Second Chance(二次机会算法)

1)定义:FIFO 的改进版,给页面第二次机会避免被置换。

2)过程:每个页面有一个“访问位”。当需要置换时,检查页面的“访问位”:如果为 0,置

换该页面。如果为 1,将其置为 0,并检查下一个页面。

3)优点:性能较好,避免置换掉仍然需要的页面。4)缺点:实现稍复杂,需要维护一个时钟指针。

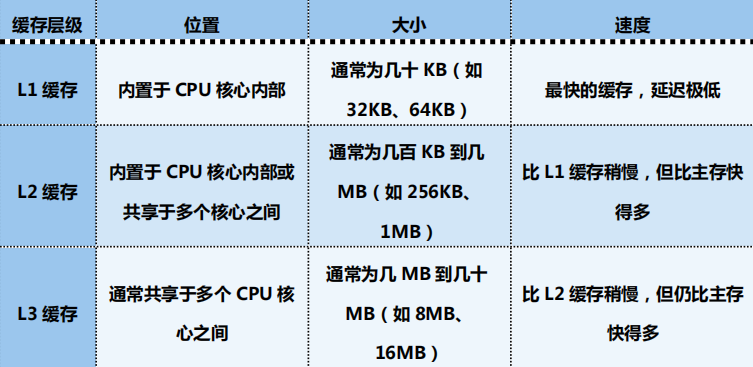

9.CPU 缓存如何影响计算性能?解释缓存的概念

(1)缓存的概念

定义:缓存(Cache)是一种临时存储数据的高效存储器,位于 CPU 和主存之间,用于存储经

常访问的数据。

目的:缓存的主要目的是加速数据访问速度,减少从主存获取数据的延迟,提高 CPU 的处理性

能。

(2)缓存的优点

加速数据访问:

原理:缓存存储的是 CPU 经常访问的数据,通过减少访问主存的次数,提高了数据访问速度。

效果:提高了 CPU 的处理性能,减少了处理等待时间。

减少内存延迟:

原理:从缓存中获取数据的速度远高于从主存中获取数据的速度。

效果:减少了数据访问的延迟,提高了程序的执行效率。58. 什么是超线程技术,它如何影响

10.超线程

(1)超线程技术的概念

1)定义:超线程技术(Hyper-Threading Technology,HTT)是一种同时多线程(SMT)技

术,使一个物理处理器核心能够模拟两个或多个逻辑处理器核心,从而提高并行处理能力。

2)实现:在物理处理器核心上增加一些额外的硬件资源,如寄存器、队列等,以便能够在同一

时间处理多个线程的指令。

(2)超线程技术的目标

1)提高资源利用率:通过让单个物理核心同时处理多个线程,最大化利用 CPU 的计算资源,

减少资源闲置时间。

2)提高并行处理能力:在多线程应用程序中,超线程技术可以显著提高并行处理能力,从而提

升整体性能。

(3)超线程技术的优点

1)提高系统性能:

并行处理:在多线程环境下,超线程技术能够让更多的线程并行执行,提高任务处理的速度。

响应速度:在处理多个任务时,超线程技术可以提高系统的响应速度,减少等待时间。

2)提升资源利用率:

硬件资源共享:超线程技术通过共享处理器核心的硬件资源,提高了资源的利用效率,减少了

资源的闲置。

降低延迟:通过同时处理多个线程,超线程技术可以有效降低处理任务的延迟。

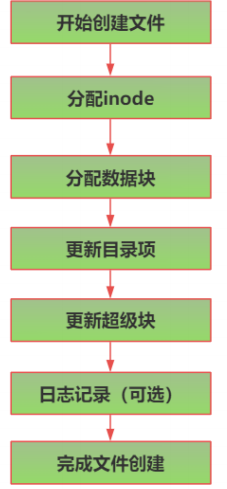

11.文件系统在创建文件时进行了哪些底层操作

(1)分配 inode:

1)定义:inode 是文件系统中用来存储文件元数据的结构,包含文件大小、权限、时间戳等信

息。

2)过程:文件系统在创建文件时,为文件分配一个唯一的 inode 编号,并在 inode 表中创建相应的 inode 条目。

(2)分配数据块:

1)定义:数据块是文件系统中用于存储文件实际数据的基本单位。

2)过程:文件系统根据文件大小和需要,为文件分配一个或多个数据块,并将这些数据块的地

址记录在 inode 中。

(3)更新目录项:

1)定义:目录项是目录中记录文件信息的条目,包含文件名和对应的 inode 编号。

2)过程:在文件所在的目录中,创建一个新的目录项,记录新文件的文件名和分配给它的 inode

编号。

(4)更新超级块:

1)定义:超级块是文件系统的控制结构,包含文件系统的总体信息,如总的 inode 数量、总

的数据块数量、可用的 inode 和数据块数量等。

2)过程:文件系统更新超级块中的信息,如已分配的 inode 数量和数据块数量,反映文件系

统的当前状态。

(5)日志记录(可选):

1)定义:日志记录是文件系统为保持一致性和快速恢复而记录的操作日志。

2)过程:在支持日志的文件系统中(如 ext4),文件创建操作会被记录在日志中,以便在系

统崩溃后进行恢复

12.非阻塞 I/O 与异步 I/O 的区别及其实现机制

(1)非阻塞 I/O

非阻塞 I/O 是指 I/O 操作不会阻塞进程,I/O 操作立即返回,不等待操作完成。应用程序需要

主动检查操作的完成状态。

实现机制:

1)设置非阻塞标志:通过系统调用设置文件描述符的非阻塞标志(如 O_NONBLOCK)

2)轮询:应用程序通过轮询方式反复检查 I/O 操作的状态。

3)使用 select/poll/epoll:利用这些系统调用来监视多个文件描述符,检测哪些文件描述符

可以进行 I/O 操作。

(2)异步 I/O

异步 I/O 是指 I/O 操作在后台进行,操作完成后通过回调函数、信号或事件驱动机制通知应用

程序。

实现机制:

1)POSIX AIO:使用 aio_read、aio_write 等异步 I/O 系统调用,操作完成后通过信号或回调

函数通知。

2)Windows IOCP:使用 I/O 完成端口(I/O Completion Ports)机制,实现高效的异步 I/O

操作。

3)事件驱动:利用事件循环机制,在操作完成时触发事件通知应用程序。

13.直接 I/O(Direct I/O)和页面缓存(PageCache)的作用是什么

(1)直接 I/O(Direct I/O)

直接 I/O 是一种绕过操作系统的页面缓存,直接将数据从用户空间读写到磁盘的方法。

作用:

1)减少内存拷贝:直接 I/O 绕过页面缓存,避免了从内存到缓存再到磁盘的多次拷贝,直接从

用户空间读写数据到磁盘。

2)降低 CPU 消耗:减少了由于内存拷贝和缓存管理带来的 CPU 开销,提高了系统效率。

3)提高数据一致性:由于数据直接写入磁盘,避免了页面缓存中的数据与磁盘数据不一致的问

题,适用于对数据一致性要求高的应用,如数据库系统。

(2)页面缓存(PageCache)

页面缓存是操作系统在内存中为文件数据保留的缓冲区,用于加速文件读取和写入操作。

作用:

1)提高文件读取速度:通过将文件数据缓存在内存中,可以快速访问文件数据,减少从磁盘读

取数据的延迟。

2)减少磁盘 I/O 操作:在内存中缓存文件数据,减少了对磁盘的频繁访问,延长了磁盘的使用

寿命。

3)提高系统性能:页面缓存通过减少磁盘 I/O 操作,提高了文件系统的整体性能,适用于读写

频繁的应用。

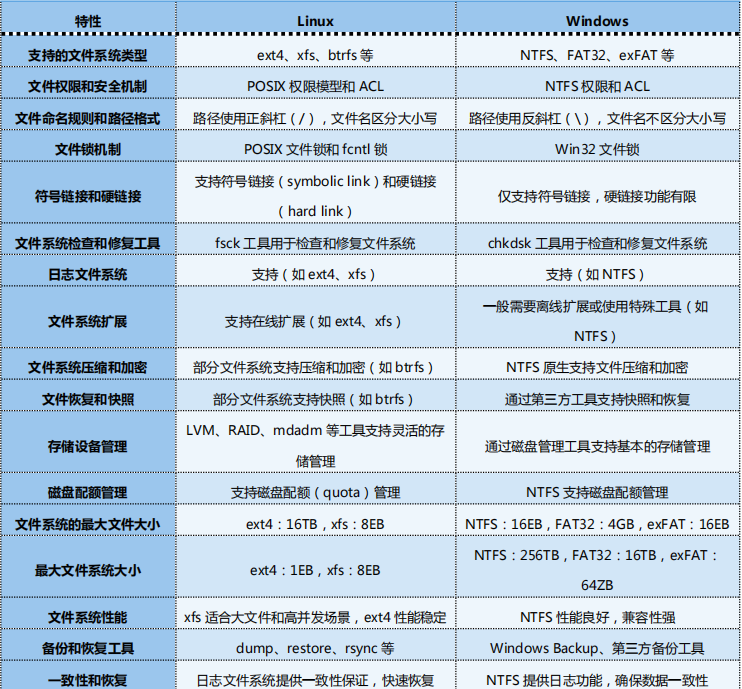

14.文件系统在WIndows和Linux下的差异

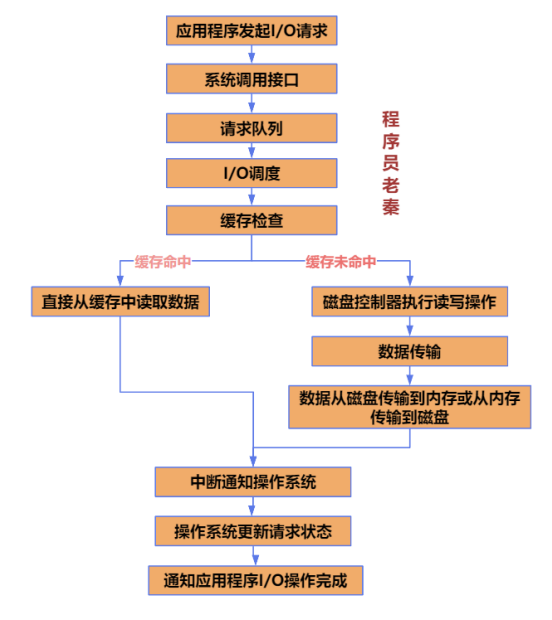

15.磁盘 I/O 的工作原理是什么

(1) I/O 请求生成

1)应用程序发起 I/O 请求:当应用程序需要读取或写入数据时,会通过系统调用(如 read、write

等)发起 I/O 请求。

2)系统调用接口:应用程序使用操作系统提供的系统调用接口发起 I/O 请求,系统调用将请求

传递给内核。

(2)请求队列

1)请求队列:操作系统内核将收到的 I/O 请求放入请求队列中,等待处理。请求队列可以是一

个简单的 FIFO 队列,也可以是更复杂的结构,用于优化处理顺序。

2)I/O 请求类型:请求队列中可以包含不同类型的 I/O 请求,如读请求、写请求、同步请求、

异步请求等。

(3) I/O 调度

1)I/O 调度算法:操作系统使用 I/O 调度算法优化请求的处理顺序,减少磁盘寻道时间和旋转

延迟。常见的调度算法包括电梯算法(Elevator Algorithm)、最短寻道时间优先算法(SSTF)、

循环扫描算法(C-SCAN)等。

2)调度过程:调度算法根据优化策略选择下一个要处理的请求,并将其发送给磁盘控制器。

(4)缓存

1)页面缓存(Page Cache):操作系统在内存中维护一个页面缓存,用于缓存最近访问的文

件数据。页面缓存可以减少磁盘 I/O 操作,提高系统性能。

2)缓存命中:当 I/O 请求的数据在页面缓存中时,直接从缓存中读取数据,避免了磁盘访问。

3)缓存未命中:当 I/O 请求的数据不在缓存中时,需要从磁盘读取数据,并将数据加载到缓存

中。

(5)磁盘控制器执行读写操作

1)磁盘控制器:磁盘控制器是计算机硬件的一部分,负责执行实际的读写操作。控制器根据操

作系统的调度命令,控制磁盘的读写头定位和数据传输。

2)数据传输:磁盘控制器将数据从磁盘传输到内存,或从内存传输到磁盘。

(6)中断通知

1)中断机制:当磁盘控制器完成一个 I/O 操作后,会发送一个中断信号给操作系统内核,通知

I/O 操作已完成。

2)中断处理程序:操作系统内核中的中断处理程序处理中断信号,更新请求状态,并通知相应

的应用程序 I/O 操作已完成

16.系统调用是如何工作的

用户态与内核态:

用户态是应用程序运行的模式,具有较低的权限。

内核态是操作系统核心运行的模式,具有最高权限。

触发系统调用:

应用程序通过软件中断或陷阱指令触发系统调用。

CPU 切换到内核态,跳转到系统调用入口。

内核处理:

内核找到对应的系统调用处理程序并执行。

系统调用处理程序执行具体的系统操作,并返回结果。

返回用户态:

内核恢复用户态上下文,并切换回用户态。

应用程序接收到系统调用结果后继续执行。

17.用户态与内核态之间如何切换

(1)切换事件:切换事件可以是系统调用、硬件中断或异常等。

(2)陷阱指令/中断:通过执行陷阱指令或响应中断信号,CPU 切换到内核态。

(3)保存上下文:CPU 保存当前用户态的上下文,包括寄存器、程序计数器等。

(4)查找处理程序:内核查找并执行相应的处理程序。

(5)恢复上下文:处理程序执行完毕后,恢复之前保存的用户态上下文。

(6)返回用户态:CPU 切换回用户态,继续执行应用程序

18.中断的原理及其实现

中断的工作原理

(1)设备发出中断信号:

1)过程:硬件设备在需要 CPU 处理时,通过中断控制器发出中断信号。

2)目的:通知 CPU 有事件需要处理。

(2)中断控制器接收中断:

1)定义:中断控制器是负责管理中断信号的硬件组件。

2)过程:中断控制器接收来自多个设备的中断信号,并将其传递给 CPU。

(3)CPU 响应中断信号:

1)过程:CPU 在接收到中断信号后,停止当前程序的执行,并保存当前上下文。

2)作用:确保中断处理程序执行完毕后,能够继续执行中断前的任务。

(4)切换到内核态:

1)过程:CPU 更新程序状态字(PSW),切换到内核态。

2)作用:允许访问内核资源,并执行中断处理程序。

(5)查找中断处理程序:

1)过程:内核根据中断向量表查找对应的中断处理程序。

2)作用:确定中断处理逻辑,并执行相应的操作。

(6)执行中断处理程序:

1)过程:中断处理程序执行具体的处理操作,如读取设备数据、处理异常等。

2)返回结果:处理程序执行完毕后,将结果返回给内核。

(7)恢复上下文:

1)过程:中断处理程序完成后,内核恢复之前保存的上下文。

2)作用:确保 CPU 能够继续执行中断前的任务。

(8)返回之前的任务:

1)过程:CPU 切换回用户态,继续执行中断前的任务。

2)目的:确保系统正常运行,不受中断处理的影响。

19.硬中断和软中断的区别

20.如何减少用户态与内核态的切换

(1)批量处理系统调用:合并多个系统调用为一个,减少切换次数。例如,使用 sendmsg

和 recvmsg 一次性发送和接收多个消息。

(2)减少不必要的系统调用:优化代码,避免不必要的系统调用。例如,减少文件操作中的

open 和 close 次数。

(3)使用零拷贝技术:减少数据在用户态和内核态之间的复制。例如,使用 sendfile 函数直

接发送文件内容。

(4)使用高效的 I/O 多路复用:使用 epoll 等高效的 I/O 多路复用技术,减少阻塞 I/O 带

来的切换。例如,在高并发网络编程中使用 epoll。

(5)减少上下文切换:优化调度和锁机制,减少任务之间的切换次数。例如,使用锁的粒度减

小,并发控制策略优化。

21.如何使用 GDB 工具调试

(1)启动和退出:

1)启动:gdb <程序>

2)退出:quit

(2)断点设置:

1)设置断点:break <位置>

2)设置观察点:watch <表达式>

3)清除断点:clear <位置>

(3)程序控制:

1)运行程序:run2)继续执行:continue

3)单步执行:next(不进入函数)、step(进入函数)

4)执行至函数返回:finish

(4)查看信息:

1)打印变量:print <变量>

2)查看调用栈:backtrace

3)查看局部变量:info locals

4)查看所有线程:info threads

(5)调试线程:

1)切换线程:thread <线程号>

2)所有线程执行命令:thread apply all <命令>

3)查看线程信息:info threads

22.如何检测死锁

分析系统日志:检查系统日志中的死锁相关信息。

使用调试工具:如 GDB 和 Valgrind 来检测死锁。

添加超时机制:在获取锁时添加超时机制,超时后放弃锁定操作。

资源分配图:绘制资源分配图,分析死锁情况。

死锁检测算法:实现死锁检测算法,如银行家算法

23.Coredump 文件是如何生成的?如何利用它进行错误分析

Coredump 文件是当程序发生崩溃时,操作系统生成的内存快照文件。它包含了程序崩溃时的

内存内容、寄存器状态和其它调试信息。通过分析 Coredump 文件,可以了解程序崩溃的原因,

找到并修复代码中的错误。

使用 GDB 加载 Coredump 文件

24.内存溢出与内存泄漏有什么不同?

25.调试方法有哪些?说出优缺点?

26.如何监控服务器 CPU 信息、内存使用率?

27.动态库与静态库的区别?

28.编译器按字节对齐的原因是什么

编译器在生成机器代码时,通常会按照一定的字节对齐规则来安排数据在内存中的存储位置。

字节对齐是一种将数据按照特定字节边界存放的方式,如 4 字节、8 字节或 16 字节边界。以下是编

译器按字节对齐的主要原因和优势:

1.提高内存访问效率

1.1 避免跨越边界访问

当数据存储在内存中时,如果数据跨越了多个内存单元的边界(如一个 32 位整数跨越了两个 4

字节的内存单元),则 CPU 需要进行多次内存访问才能读取或写入该数据。这种情况下,内存访问

效率会显著降低。通过字节对齐,数据可以存放在单一的内存单元中,避免跨越边界访问,从而提

高内存访问效率。

1.2 减少 CPU 周期

对齐的数据访问通常只需一个 CPU 周期,而未对齐的数据访问可能需要多个 CPU 周期。未对

齐的访问需要额外的处理步骤,如拆分和合并数据,这会增加 CPU 的工作负担。通过字节对齐,可

以简化内存访问操作,减少 CPU 周期,提高程序运行效率。

2. 满足硬件要求

2.1 硬件对齐限制

某些硬件平台(如 ARM、MIPS)要求数据必须按特定的字节边界对齐,否则会引发访问错误

或性能下降。这是因为这些硬件在设计上假定了对齐的内存访问,从而简化了内存访问的电路设计。

如果数据未对齐,硬件需要额外的逻辑来处理未对齐的数据访问,增加了硬件设计的复杂性和成本。

3. 简化硬件设计

3.1 简化总线设计

对齐的数据更易于硬件设计,尤其是在内存总线的设计上。内存总线通常按照特定的字节宽度

设计,如 32 位或 64 位。如果数据未对齐,总线需要额外的逻辑来处理跨越多个总线周期的数据传

输,这会增加总线设计的复杂性和成本。通过字节对齐,可以简化总线设计,减少硬件设计的复杂

性和成本

29.字节序及其对系统的影响

字节序(Byte Order)是指在计算机内存中,多字节数据(如整数、浮点数等)存储的顺序。主要有两种字节序:大端字节序(Big Endian)和小端字节序(Little Endian)。这两种字节序对系统的影响主要体现在以下几个方面:

1. 数据存储和读取

- 大端字节序:在这种字节序中,数据的高位字节存储在低地址,低位字节存储在高地址。例如,对于一个 4 字节的整数

0x12345678,其存储顺序为12 34 56 78。 - 小端字节序:在小端字节序中,数据的低位字节存储在低地址,高位字节存储在高地址。对于同样的整数

0x12345678,其存储顺序为78 56 34 12。

这种差异在多个平台之间传输数据时可能导致解释错误,特别是在网络通信和文件存储中。

2. 跨平台兼容性

在不同的计算机架构中,可能使用不同的字节序。例如,Intel x86 架构使用小端字节序,而某些网络协议和大多数 RISC 架构使用大端字节序。在进行跨平台的数据交换时,必须确保数据以正确的字节序进行解释和处理。这通常需要在网络协议或文件格式中明确规定字节序。

3. 性能影响

在某些情况下,字节序的选择可能会影响程序的性能。例如,在进行大量数据处理时,某些操作可能在特定字节序下更高效。如果程序需要频繁地进行字节序转换,这可能会引入额外的计算开销,从而影响整体性能。

4. 编程语言和库的支持

不同的编程语言和库可能对字节序有不同的处理方式。在某些语言中,开发者需要手动处理字节序,而在其他语言中,可能会提供内置的函数来处理字节序转换。这要求开发者在选择编程语言和库时考虑字节序的兼容性。

5. 安全性问题

不正确的字节序处理可能导致安全漏洞,例如缓冲区溢出或数据损坏。在网络通信或文件解析中,攻击者可能利用字节序问题来构造恶意数据包,从而破坏系统的正常运行。

30.源码到可执行文件的过程是什么

1. 预处理(Preprocessing)

预处理是编译的第一个阶段,主要任务是处理以 # 开头的预处理指令。预处理器根据这些指令

对源代码进行转换,生成预处理后的代码。

1.1 处理头文件

预处理器会将所有的 #include 指令替换为相应头文件的内容。这使得头文件中的声明和定义

能够在源文件中使用。

1.2 宏替换

预处理器会将所有的宏定义(#define)替换为相应的宏值。这包括简单的常量替换和复杂的宏

函数替换。

1.3 条件编译

预处理器会根据条件编译指令(如 #ifdef、#ifndef、#if、#endif)选择性地编译代码。这使

得程序可以根据不同的条件编译不同的代码。

2. 编译(Compilation)

编译是将预处理后的源代码转换为中间代码或目标代码的过程。编译阶段主要包括语法分析、

语义分析和生成中间代码。2.1 语法分析

编译器会检查代码的语法是否正确,确保代码符合编程语言的语法规则。语法分析的结果是语

法树(Syntax Tree)。

2.2 语义分析

编译器会检查代码的语义是否正确,确保变量和函数的使用符合其定义。语义分析的结果是抽

象语法树(Abstract Syntax Tree,AST)。

2.3 生成中间代码

编译器会将抽象语法树转换为中间代码(Intermediate Code),中间代码是独立于具体机器

的代码形式。常见的中间代码形式有三地址代码(Three-Address Code)和中间表示(Intermediate

Representation,IR)。

3. 汇编(Assembly)

汇编是将中间代码转换为机器代码的过程。汇编器会将中间代码指令逐条翻译为机器指令,生

成目标文件(Object File)。

4. 链接(Linking)

链接是将多个目标文件和库文件合并为一个可执行文件的过程。链接器会将所有的目标文件和

库文件中的符号表(Symbol Table)合并,解决符号引用,并生成最终的可执行文件。

4.1 合并文件

链接器会将多个目标文件和库文件中的代码和数据合并为一个文件,并解决所有的外部符号引

用。

4.2 生成可执行文件

链接器会生成最终的可执行文件,并将所有的符号表、代码段和数据段合并到一个文件中

31.DMA

(1)DMA 的工作原理

DMA 控制器是实现直接内存访问的核心组件。它负责管理外设和内存之间的数据传输。当外设

需要传输数据时,DMA 控制器接管总线控制权,直接访问内存。DMA 控制器在内存和外设之间传

输数据,而不需要 CPU 的干预。

(2)DMA 的基本步骤

1)初始化:CPU 设置 DMA 控制器的传输参数,包括源地址、目的地址和传输大小。2)启动传输:CPU 启动 DMA 控制器。

3)数据传输:DMA 控制器接管总线控制权,直接在内存和外设之间传输数据。

4)传输完成:DMA 控制器发送中断信号通知 CPU 数据传输完成