知识列表

- 不同进程间是否可以共享内存?包括父子进程

- 如何设置用户进程的资源限制

- 如何使用互斥锁实现读写锁,特别是写者优先策略

- std::unique_lock

- 死锁

- 内存屏障

- 条件变量的缺点,为何需要与互斥锁配合使用

- 原子操作

- 线程从任务队列中取任务时,有办法不使用锁

- 介绍CAS中的ABA问题及其解决方案

- 并发和并行

- 不同类型的锁及其用途

- 线程属性值如何修改

- 内存管理与虚拟内存

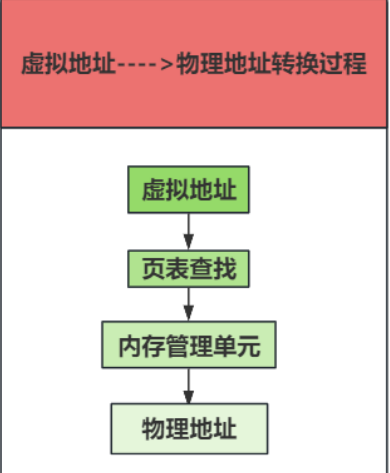

- 如何将虚拟地址转换成物理地址?页表和内存管理单元(MMU)的角色是什么?

- 操作系统如何分配和管理内存?malloc和new的内存分配机制

- 虚拟内存系统中的内存分配策略有哪些?连续与非连续内存管理的区别

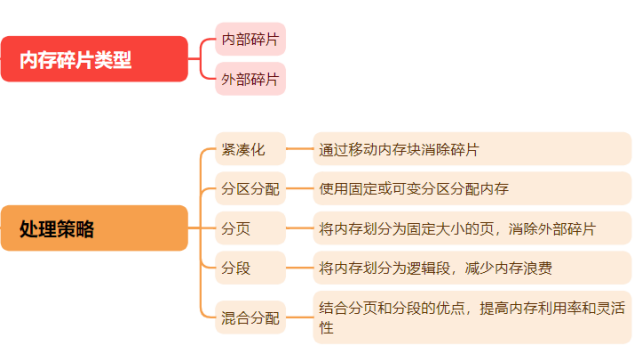

- 内存碎片的处理策略

- 内存池如何保证不产生内存碎片

1.不同进程间是否可以共享内存?包括父子进程

不同进程间可以共享内存,包括父子进程,共享内存是一种高效的进程间通信(IPC)机制,允许多个进程访问同一块内存区域。

在POSIX下如何实现共享内存:

使用shm_open创建共享内存对象

使用mmap将共享内存映射到进程的地址空间

是哟shm_unlink删除共享内存对象

const char* name = "/my_shared_memory";

const size_t SIZE = 4096;

// 创建共享内存对象

int shm_fd = shm_open(name, O_CREAT | O_RDWR, 0666);

ftruncate(shm_fd, SIZE);

// 映射共享内存

void* ptr = mmap(0, SIZE, PROT_READ | PROT_WRITE, MAP_SHARED, shm_fd, 0);

2.如何设置用户进程的资源限制

- 在Linux系统中可以使用ulimit命令,可以设置限制的资源包括:最大文件大小,最大栈大小,最大进程数等:ulimit -u 100:限制最大线程数;ulimit -m 1048576限制最大内存使用为1GB

- 使用setrlimit函数struct rlimit limit;

// 设置最大进程数(线程数)

limit.rlim_cur = 100; // 软限制

limit.rlim_max = 100; // 硬限制

if (setrlimit(RLIMIT_NPROC, &limit) != 0) {

perror(“setrlimit”);

return 1;

}

// 设置最大内存使用

limit.rlim_cur = 1 * 1024 * 1024 * 1024; // 1 GB

limit.rlim_max = 1 * 1024 * 1024 * 1024; // 1 GB

if (setrlimit(RLIMIT_AS, &limit) != 0) {

perror(“setrlimit”);

return 1;

} - 使用控制组:cgroups是Linux内核提供的一种机制,用于限制,隔离和监控进程组的资源使用。# 创建新的 cgroup

sudo cgcreate -g memory,cpu:/my_cgroup

# 限制内存使用

sudo cgset -r memory.limit_in_bytes=1G my_cgroup

# 限制 CPU 使用

sudo cgset -r cpu.shares=512 my_cgroup

3.如何使用互斥锁实现读写锁,特别是写者优先策略

#include <iostream>

#include <mutex>

#include <thread>

#include <condition_variable>

class ReadWriteLock {

std::mutex mtx; // 互斥锁,用于同步对以下变量的访问

std::condition_variable reader_ok; // 条件变量,让读者等待直到可以安全地读取

std::condition_variable writer_ok; // 条件变量,让写者等待直到可以安全地写入

int active_readers = 0; // 当前活跃的读者数量

int waiting_writers = 0; // 正在等待的写者数量

int active_writers = 0; // 当前活跃的写者数量(0 或 1)

public:

void read_lock() {

std::unique_lock<std::mutex> lock(mtx);

while (active_writers > 0 || waiting_writers > 0) {

reader_ok.wait(lock);

}

active_readers++;

}

void read_unlock() {

std::unique_lock<std::mutex> lock(mtx);

active_readers--;

if (active_readers == 0 && waiting_writers > 0) {

writer_ok.notify_one();

}

}

void write_lock() {

std::unique_lock<std::mutex> lock(mtx);

waiting_writers++;

while (active_readers > 0 || active_writers > 0) {

writer_ok.wait(lock);

}

waiting_writers--;

active_writers = 1;

}

void write_unlock() {

std::unique_lock<std::mutex> lock(mtx);

active_writers = 0;

reader_ok.notify_all();

writer_ok.notify_one();

}

};

ReadWriteLock rw_lock;

void reader_function(int id) {

rw_lock.read_lock();

std::cout << "Reader " << id << " is reading." << std::endl;

std::this_thread::sleep_for(std::chrono::milliseconds(100)); // 模拟读操作耗时

std::cout << "Reader " << id << " has finished reading." << std::endl;

rw_lock.read_unlock();

}

void writer_function(int id) {

rw_lock.write_lock();

std::cout << "Writer " << id << " is writing." << std::endl;

std::this_thread::sleep_for(std::chrono::milliseconds(100)); // 模拟写操作耗时

std::cout << "Writer " << id << " has finished writing." << std::endl;

rw_lock.write_unlock();

}

int main()

{

std::thread reads[5], writes[2];

for (int i = 0; i < 2; i++) {

writes[i] = std::thread(writer_function, i + 1);

}

for (int i = 0; i < 5; i++)

{

reads[i] = std::thread(reader_function, i + 1);

}

for (auto& writer : writes) {

writer.join();

}

for (auto& reader : reads) {

reader.join();

}

return 0;

}

4.std::unique_lock

std::unique_lock是一个用于管理互斥量的锁定,与std::lock_guard相比,std::unqiue_lock提供了更大的灵活性

- RAII(资源获取即初始化)std::unique_lock在构造时自动锁定互斥量,并在析构时自动解锁,确保在异常下也能正确解放

- 灵活的锁定策略std::unique_lock允许在构造时指定锁定状态:立即锁定,延迟锁定或不锁定std::unique_lock<std::mutex> lock(mutex, std::defer_lock); // 构造时不锁定std::unique_lock<std::mutex> lock(mutex, std::try_to_lock); // 尝试锁定还可以再运行时手动解锁和锁定互斥量

- 可移动语义std::unique_lock是可移动的

- 条件变量的支持std::unique_lock可以与条件变量一起使用,允许在等待条件变量时自动解锁或重新锁定互斥量

unique_lock调用wait方法: cv.wait(lock, [] { return ready; });

- 解锁互斥量:在调用

wait的时候,std::unique_lock会自动释放它所管理的互斥量(mutex),以允许其他线程访问被保护的共享数据。 - 等待条件:当前线程会被阻塞,直到条件变量被通知(通过

notify_one或notify_all),这意味着某个条件已经改变。 - 重新锁定互斥量:当条件变量被通知后,

wait方法会重新锁定互斥量,然后返回控制权给调用线程。此时,线程可以安全地检查共享数据的状态。

5.死锁

死锁是在多线程或多进程编程中的一种情况,其中一组进程或线程每个都在等待其他进程释放资源,或者等待其他进程执行操作,而这些进程或线程又在等待第一个进程释放资源。结果是,没有一个进程能够向前推进,整个系统都陷入停滞

死锁的发生通常依赖于以下四个条件,这些条件被称为死锁的四个必要条件:

1)互斥条件(Mutual Exclusion):至少有一个资源必须处于非共享模式,即一次只有一个

进程可以使用该资源。如果另一个进程也需要该资源,则必须等待直到资源被释放。

2)持有和等待条件(Hold and Wait):一个进程必须已经持有至少一个资源,并且正在等待

获取额外的被当前其他进程持有的资源。

3)非抢占条件(No Preemption):资源不能被抢占,即资源只能由持有它的进程在使用完

毕后自愿释放。

4)循环等待条件(Circular Wait):必须有一个进程—资源的闭环链,其中每个进程至少持

有一个资源,并等待获取另一个链中下一个进程所持有的资源。

死锁的解决方法

解决死锁问题通常可以通过预防、避免或检测和恢复的方法来处理。

预防死锁

预防死锁涉及到破坏死锁的四个必要条件中的至少一个:

1)破坏互斥条件:这是很难做到的,因为某些资源天生是不可共享的。

2)破坏持有和等待条件:可以要求进程在开始执行前一次性请求所有所需的资源。

3)破坏非抢占条件:如果发现运行过程中会导致死锁,系统可以强制抢占已分配的资源。

4)破坏循环等待条件:对所有资源类型进行排序,并强制每个进程按顺序请求资源,这样就不

会形成环形等待链

避免死锁

银行家算法:系统在分配资源之前先检查这次分配是否可能导致系统进入不安全状态,如果可能导致,就不分配这个资源

检测和恢复死锁

死锁检测:定期使用资源分配图或其他算法来检测系统是否进入死锁状态。死锁恢复:一旦检测到死锁,系统可以采取措施解决,比如终止一个或多个进程,回滚操作或强制释放资源

6.内存屏障

内存屏障也称内存栅栏,用于控制CPU和编译器对内存操作顺序的一种机制,内存屏障可以确保特定的内存操作在程序执行的顺序不会被重排序,从而保证多线程程序中内存访问的正确性

- 全局内存屏障(Full Memory Barrier)全局内存屏障确保在屏障前的所有内存操作在屏障后的内存操作之前完成。它会组织所有类型的内存操作(读取和写入)重排序。

- 读内存屏障(Read Memory Barrier)读内存屏障确保在屏障前的所有读操作在屏障后的读操作之前完成。它会阻止读操作被重排序。

- 写内存屏障(Write Memory Barrier)写内存屏障确保在屏障前的所有写操作在屏障后的写操作之前完成。它会阻止写操作被重排序

- 依赖性屏障(Dependency Barrier)依赖性屏障确保依赖关系的顺序不会被重排序,保证依赖于先前操作的内存访问不会被重排序到先前操作之前。这种屏障主要用于保护数据依赖

7.条件变量的缺点,为何需要与互斥锁配合使用

条件变量的缺点

- 复杂性:条件变量的使用比简单的互斥锁复杂,需要正确的同步和逻辑来避免竞争条件和死锁

- 虚假唤醒:条件变量可能会在没有明确通知的情况下唤醒等待线程,即假唤醒。需要额外的逻辑来反复检查条件

- 资源开销:条件变量的实现可能涉及系统调用,导致额外的资源开销和性能影响

- 等待条件的复杂管理:条件变量要求等待条件在某些情况下能够正确地重新检查,这通常通过循环来实现,但增加了代码的复杂性。

需要与互斥锁配合

- 需要共享资源的访问:条件变量用于线程之间的同步,需要要与互斥锁一起使用来保护共享资源的访问。互斥锁确保在检查和修改共享资源时,不会有其他线程并发访问这些资源。2)防止竞争条件:在等待条件变量的线程在被唤醒后,需要重新检查条件是否成立。互斥锁可以防止其他线程在条件检查和等待之间修改共享资源,避免竞争条件。3)确保原子操作:等待和唤醒操作通常需要原子性。互斥锁可以确保线程在等待条件变量时,不会被其他线程打扰,从而实现原子操作。4)避免假唤醒问题:条件变量可能会产生假唤醒,通过互斥锁可以在被唤醒后重新检查条件是否满足,确保线程不会在不适当的时候继续执行

8.原子操作

原子操作实现方式:

- 硬件支持:大多数现代处理器提供特殊的原子指令,如Compare-and-Swap(CAS),Test-and-Set(TAS),Fetch-and-Add,这些指令在单个指令周期内完成检查和修改值的操作,确保了操作的原子性

- 操作系统支持:操作系统通过禁用中断创建临界区,防止上下文切换,确保代码段在执行过程中不被中断,主要用于单处理器系统或控制特定硬件交互

9.线程从任务队列中取任务时,有办法不使用锁

无锁编程利用原子操作来保证数据结构的一致性,避免了锁的使用,减少了线程阻塞和上下文切换的开销。无锁队列适用于生产者消费者模型,其中多个生产者和消费者线程频繁地入队和出队操作,而不会彼此干扰

// 定义一个泛型无锁队列

template <typename T>

class LockFreeQueue {

private:

// 节点结构

struct Node {

T data; // 存储的数据

std::atomic<Node*> next{ nullptr }; // 指向下一个节点的原子指针

explicit Node(T val) : data(val) {} // 节点构造函数

};

std::atomic<Node*> head; // 队列头部

std::atomic<Node*> tail; // 队列尾部

public:

// 构造函数

LockFreeQueue() {

Node* dummy = new Node(T()); // 创建一个哑元节点

head.store(dummy, std::memory_order_relaxed); // 初始化头部

tail.store(dummy, std::memory_order_relaxed); // 初始化尾部

}

// 析构函数

~LockFreeQueue() {

Node* node;

while ((node = head.load(std::memory_order_relaxed))) {

head.store(node->next, std::memory_order_relaxed);

delete node; // 删除节点释放内存

}

}

// 入队操作

void push(const T& value) {

Node* newNode = new Node(value); // 创建新节点

Node* oldTail = tail.load(std::memory_order_relaxed);

// 尝试更新尾部

while (!tail.compare_exchange_weak(oldTail, newNode,

std::memory_order_release,

std::memory_order_relaxed)) {

oldTail = tail.load(std::memory_order_relaxed); // 重新加载尾部

}

// 设置新节点为尾部节点的下一个节点

oldTail->next.store(newNode, std::memory_order_release);

}

// 出队操作

bool pop(T& value) {

Node* oldHead = head.load(std::memory_order_consume);

Node* tailNode = tail.load(std::memory_order_relaxed);

Node* next = oldHead->next.load(std::memory_order_relaxed);

if (oldHead == tailNode) {

return false; // 队列为空

}

value = next->data; // 读取数据

head.store(next, std::memory_order_release); // 移动头部指针到下一个节点

delete oldHead; // 删除旧的头部节点

return true;

}

};

int main() {

LockFreeQueue<int> queue;

// 生产者线程

std::thread producer([&]() {

for (int i = 0; i < 100; ++i) {

queue.push(i); // 生产者线程向队列中推送数据

}

});

// 消费者线程

std::thread consumer([&]() {

int value;

for (int i = 0; i < 100; ++i) {

while (!queue.pop(value)) { // 消费者线程从队列中获取数据

std::this_thread::sleep_for(std::chrono::milliseconds(1)); // 如果队列为空,则稍等片刻

}

std::cout << "Consumed: " << value << std::endl; // 输出消费的数据

}

});

producer.join(); // 等待生产者线程结束

consumer.join(); // 等待消费者线程结束

return 0;

}

10.介绍CAS中的ABA问题及其解决方案

ABA问题

ABA问题是在使用原子操作比如Compare-and-Swap时遇到的问题,CAS操作检查一个位置的值如果与预期相同,则将其更新为新值。ABA问题发生在一个位置的值原本是A,被一个线程改为B,然后又改为A,另一个线程使用CAS操作检查该值(期望它仍然为A),然后进行更新,尽管此位置的值看起来未变,但其实它在此期间可能已经被改变过。

ABA问题的影响

这种情况在多线程程序中可能会导致严重的错误,因为虽然“当前值”与“期望值”相同,线

程操作的上下文可能已经完全改变。例如,如果这个值是一个指针,它可能已经被释放并重新分配,再次使用它就可能导致未定义行为或安全漏洞

解决 ABA 问题的策略

1)使用版本号:一种常用的解决方法是将版本号与数据结合。每次变量被修改时,版本号增加。

这样,CAS 操作不仅比较数据值还比较版本号。如果一个变量从 A 变为 B 再变回 A,版本号将反映

出这一变化,使得 CAS 操作能够检测到中间的变化。

2)使用双字(Double-Word)CAS:双字 CAS 可以同时比较和交换两个连续的字(通常是 64

位系统中的 128 位)。这使得开发者可以将一个额外的计数器或版本号与数据一起存储和检查。这

种方法在现代处理器中已经得到了支持,比如在 Intel 的处理器中可以使用 CMPXCHG16B 指令

11.并发和并行

并发(Concurrency):

1)多个任务在同一时间段内交替进行。

2)任务切换提高响应性和资源利用率。

3)可以在单核处理器上实现。

4)任务之间是交替执行的,给人一种同时进行的错觉。

并行(Parallelism):

1)多个任务在同一时刻同时进行。

2)需要多核处理器或多个处理器。

3)提高计算速度和处理能力。

4)任务之间是真正的同时执行

应用场景

并发:适用于 I/O 密集型任务(如文件读取、网络通信),可以提高系统的响应性。

并行:适用于计算密集型任务(如矩阵乘法、大数据处理),可以显著缩短计算时间。

12.不同类型的锁及其用途

(1)互斥锁(Mutex)

作用:确保同时只有一个线程可以执行某段代码或访问某个资源。

使用场景:适用于保护共享数据,如全局变量或数据结构,防止并发修改导致的数据不一致。

特点:简单易用,但可能导致死锁和优先级反转等问题。

(2)递归锁(Recursive Mutex)

作用:允许同一个线程多次获得同一把锁。

使用场景:适用于递归函数或可以被同一个线程多次调用的代码块中,需要重复锁定。

特点:避免了因重入而死锁的问题,但使用不当可能会导致锁保持时间过长。

(3)读写锁(Read-Write Lock)

作用:允许多个读者同时访问资源,但写者访问时独占资源。

使用场景:适用于读多写少的数据结构,可以显著提高读操作的并发性。

特点:提高了读操作的性能,但实现相对复杂,可能引入写者饥饿问题。

(4)自旋锁(Spinlock)

作用:通过忙等(自旋)而不是休眠来等待锁的释放。

使用场景:适用于锁持有时间极短的场景,以减少线程上下文切换的开销。

特点:高效于处理器密集型环境,但在单处理器系统或锁持有时间较长的情况下效率低下

13.线程属性值如何修改

在使用POSIX线程编程时,可以通过pthread_attr_t结构来设置和修改线程属性值。常见的线程属性有栈大小,栈地址,调度策略和优先级,继承调度属性,分离状态等

pthread_attr_t attr;

pthread_attr_init(&attr);

size_t stacksize = 2 * 1024 * 1024;

pthread_attr_setstacksize(&attr, stacksize);

pthread_attr_getstacksize(&attr, &stacksize);

// 设置分离状态

pthread_attr_setdetachstate(&attr, PTHREAD_CREATE_DETACHED);

14.内存管理与虚拟内存

虚拟内存是操作系统创建的抽象内存空间,通过硬件和软件结合实现;虚拟内存容量卡伊超过物理内存大小,通过使用硬盘上的交换空间(swap space)扩展;通过页表和地址映射机制转换为物理地址,再被CPU访问;每个进程都有独立的虚拟地址空间,增强了进程之间的隔离;利用物理内存的缓存特性,提高内存访问速度;提供每个进程独立的地址空间,避免进程之间的内容干扰,提高了系统安全性和稳定性

物理内存是实际存在的硬件内存(如RAM),容量由物理内存硬件的大小决定,直接被CPU访问,多个进程共享物理内存,需要显式管理访问权限;通过硬件高速访问;需要额外管理,避免进程间冲突

15.如何将虚拟地址转换成物理地址?页表和内存管理单元(MMU)的角色是什么?

虚拟地址转换成物理地址

- 获取页目录表基地址:从 CR3 寄存器中读取页目录表的基地址,以确定当前进程的页表结构。

- 计算页目录索引:根据虚拟地址的格式提取出页目录索引,以定位对应的页目录项。

- 查找页目录表:利用计算得到的页目录索引,在页目录表中查找相应的页表基地址。

- 计算页表索引:从虚拟地址中提取页表索引,以确定所需访问的页表项。

- 查找页表:使用计算出的页表索引,从相应的页表中检索物理页框号。

- 计算物理地址:将获取的物理页框号与虚拟地址中的页内偏移相结合,生成最终的物理地址。

内存管理单元

- 内存管理单元(MMU):MMU 是计算机系统中的一个关键硬件组件,主要负责将中央处理器(CPU)生成的虚拟地址转换为物理地址。通过这种地址转换,MMU 实现了虚拟内存的管理,使得程序可以使用比实际物理内存更大的地址空间,同时提供了内存保护和隔离功能。

- 虚拟地址访问过程:当 CPU 试图访问内存时,MMU 会截获生成的虚拟地址。它随后根据预先建立的页表进行查找,以确定该虚拟地址对应的物理地址。通过这一过程,MMU 能够有效地将虚拟地址映射到实际的物理内存位置,从而确保 CPU 能够访问所需的数据或指令。这一机制不仅提高了内存的使用效率,还增强了系统的安全性和稳定性。

16.操作系统如何分配和管理内存?malloc和new的内存分配机制

操作系统管理

- 虚拟内存:虚拟内存概念:虚拟内存是操作系统提供的内存管理机制,通过将物理内存与虚拟地址空间分离,使每个进程拥有独立的地址空间,提升内存使用的效率和安全性虚拟地址转换:虚拟地址通过页表转换为物理地址,具体转换过程由内存管理单元(MMU)硬件实现

- 分页机制:分页:将内存划分为固定大小的块,称为页(Page),虚拟内存和物理内存都按页进行管理。每个页通常为4KB。页表:操作系统使用页表记录虚拟地址到物理地址的映射关系,每个进程有一个独立的页表页表查找:通过虚拟地址的页号在页表中查找对应的物理页框号,再加上页内偏移得到物理地址

- 分段机制:分段:内存被划分为不同的段,每个段都有不同的大小和权限,用于表示代码段,数据段,堆栈段段表:操作系统使用段表记录段的基地址和大小,通过段选择和段偏移计算物理地址

用户态内存分配

- malloc内存分配机制malloc是C语言的动态内存分配函数,malloc用于在堆上分配指定大小的内存实现机制:小内存分配,malloc从维护的空闲内存链表中查找合适的块进行分配;对于大块内存,malloc通过brk或mmap系统调用向操作系统申请新的内存区域释放内存:通过free函数释放分配的内存,将其归还到空闲链表

- new内存分配机制new是C++中的运算符,用于在堆上分配内存并调用构造函数初始化对象实现机制:调用malloc:new运算符底层通常调用malloc分配内存,调用构造函数,在分配的内存上调用对象的构造函数进行初始化释放内存:通过delete运算符释放内存并调用析构函数

17.虚拟内存系统中的内存分配策略有哪些?连续与非连续内存管理的区别

有连续内存管理和非连续内存管理

连续内存管理的内存分配方式是连续分配,内存块必须是连续的,这样会导致内存碎片多,利用率较低,实现简单,常见策略有固定分区和可变分区,地址转换是直接通过基地址和偏移计算,扩展性不灵活,难以动态调整内存大小,隔离性较差,共享内存较难

非连续分配内存分配方式是非连续分配,内存块可以分散在不同区域,内存碎片少,利用率高,实现复杂,需要页表或分段机制,常见策略有:分页,分段,段页结合,地址转换通过页表或段表查找物理地址,拓展性灵活,可以动态分配和释放内存,隔离较好,易于实现内存保护和共享

(1)连续内存管理:

1)优点:实现简单,直接通过基地址和偏移计算物理地址。

2)缺点:容易产生内存碎片,内存利用率较低,难以动态调整内存大小。

(2)非连续内存管理:

1)优点:内存利用率高,减少内存碎片,易于实现内存保护和共享,支持动态分配和释放。

2)缺点:实现复杂,需要页表或段表支持,地址转换开销较大

18.内存碎片的处理策略

为什么操作系统设计允许内存碎片的产生?

1)内存利用效率:完全避免内存碎片会导致内存管理策略过于复杂,可能降低内存利用效率。

在一些应用场景下,适当的内存碎片是可以接受的,以换取内存管理的简单性和高效性。

2)性能考虑:一些高效的内存分配策略(如分页)虽然可能产生内部碎片,但能够显著提高内

存分配和回收的速度,减少操作系统的开销。紧凑化内存碎片虽然可以消除碎片,但需要频繁移动

内存块,会导致性能下降。

3)灵活性和扩展性:非连续内存管理策略(如分页和分段)虽然可能产生内存碎片,但提供了

更大的灵活性和扩展性。分页和分段允许进程使用不连续的内存块,便于实现动态内存分配和扩展,提高内存利用率

处理策略:

19.内存池如何保证不产生内存碎片

内存池是一种内存管理技术,通过预先分配一大块内存,并将其划分为多个固定大小的小块,以满足频繁地内存分配和释放需求,内存管理负责维护这些小块的分配和释放,减少了内存碎片的产生,提高内存利用率和分配效率

(1)固定大小块分配:

1)基本原理:内存池将内存划分为大小相同的块,每次分配和释放的内存都是固定大小的块。

2)优点:由于每次分配和释放的内存块大小相同,不会出现大小不一的内存块混合在一起,从

而避免了外部碎片。

3)示例:假设内存池中每个块大小为 64 字节,那么无论何时分配或释放内存,都是以 64 字

节为单位进行。

(2)内存块复用:

1)基本原理:内存块被释放后,不会立即归还给操作系统,而是保留在内存池中,以便下次分

配时复用。

2)优点:减少了频繁分配和释放内存导致的内存碎片,同时也减少了系统调用的开销。

3)示例:当一个内存块被释放后,该块会被标记为可用,下次分配内存时,优先使用这些可用

块。

(3)分区管理:

1)基本原理:根据不同大小的内存需求,将内存池划分为多个区域,每个区域管理不同大小的

内存块。

2)优点:针对不同大小的内存分配需求,避免内存块大小不一导致的碎片问题,提高内存利用

率。

3)示例:内存池可以有多个子池,一个子池分配 64 字节块,另一个子池分配 128 字节块,根

据需求选择合适的子池进行分配。